Perfekt „eingebettet“: Von winzigen Embedded MIPI Kameras zu ultrakompakten all-in-one Embedded Vision Systemen

Vision Lösungen, die in kompaktem Design Bilderfassung und Bildverarbeitung kombinieren, werden immer kleiner, immer leistungsfähiger und in immer mehr Anwendungen „eingebettet“ – von klassischen Machine Vision Anwendungen und der industriellen Qualitätskontrolle über Fabrikautomatisierung und intelligente Haushaltsgeräte bis hin zu Fahrerassistenzsystemen und selbstfahrenden Autos, autonomen Robotern und Drohnen. Dabei hat sich die Technologie in den vergangenen 30 Jahren rasant weiterentwickelt. Entsprechend häufig und inflationär wird der Begriff „Embedded Vision“ heute verwendet. Wir wollen in diesem Blogbeitrag zeigen, was „embedded“ für uns bedeutet – und wie davon zahlreiche smarte Applikationen profitieren.

Embedded Vision Systeme – eine Definition

Embedded Systeme bezeichnen in der Regel Computersysteme, die einen Prozessor und Speicher sowie Ein-/Ausgabe- und Peripheriegeräte kombinieren, eine spezielle Funktion haben und in größere mechanische oder elektronische Systeme eingebaut sind (– so beschreibt es Wikipedia).

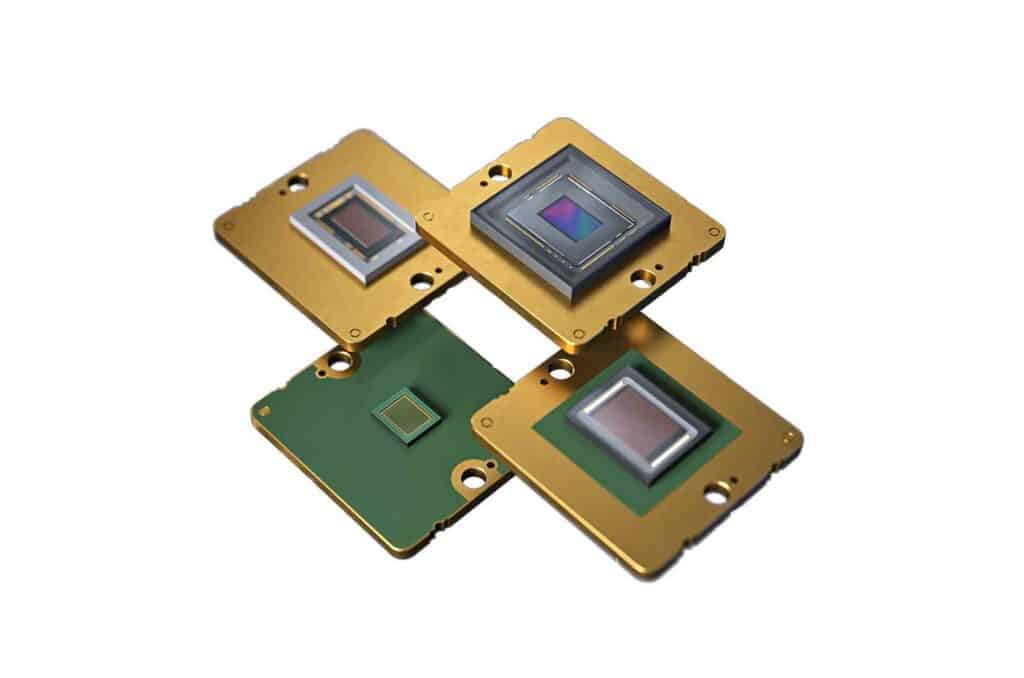

Bei Embedded Vision Systemen basieren diese Lösungen typischerweise auf einem Bildsensor zur Datenerfassung und einer Verarbeitungseinheit, z. B. einem Mikrocontroller. Mit der steigenden Anzahl an Anwendungen, bei denen Kameras als Sensoren zum Einsatz kommen, wird auch die Bezeichnung „Embedded Vision“ immer häufiger verwendet. Eine Board-Level-Kamera, zum Beispiel mit MIPI-CSI2-Interface, wird oft ebenso – und völlig korrekt – als Embedded Kamera und Embedded Vision Komponente bezeichnet wie komplexe Systeme, die ein Kameramodul, eine Verarbeitungseinheit mit Mainboard und System on Module (SoM) sowie weitere Elektronik wie Interfaceboards, digitale I/Os etc. umfassen. Weitere Komponenten wie Trigger, Beleuchtung und Optik, andere Sensoren und Software können ebenfalls Teil eines Embedded Vision Systems sein.

Ein geringer Stromverbrauch ist für viele Einsatzbereiche von Embedded Vision Systemen ebenfalls ein wichtiger Aspekt. Darüber hinaus sind robustes Design, industrietaugliche Qualität und Langzeitverfügbarkeit fest mit dem Begriff „Embedded“ verbunden. Die Technologie eignet sich damit für unterschiedlichste Geräte und Applikationen, von Consumer-Produkten bis hin zu hochspezialisierten industriellen Anwendungen.

Grundkomponenten eines Embedded Vision Systems

Vision Components: So sehen wir Embedded Vision

“Ein wichtiges Charakteristikum für Embedded Vision Systeme und den Einsatz in Industrie- und Serienprodukten sind für VC Komponenten, die perfekt auf die jeweiligen Anwendungen zugeschnitten sind. Sie verzichten auf allen unnötigen Overhead an Bauteilen und Funktionalität und sorgen damit für niedrige Stückkosten. Diese Lösungen sind so klein wie möglich und optimal geeignet für das Design von Edge Devices und mobilen Anwendungen.”

Jan Erik-Schmitt

Geschäftsführer Vision Components

Wichtige Kriterien für Embedded Vision Systeme:

- Minimale Größe – für flexible Integration

- Niedriger Stromverbrauch – für mobile Anwendungen

- Preisoptimiertes Design – für geringe Serienkosten

- Robust, langlebig und langzeitverfügbar – für den Einsatz in der Industrie

Beispiele für Embedded Vision Systeme

MIPI Kameras

Flexibel einsetzbar, dank der MIPI CSI2-Schnittstelle mit gängigen Prozessorboards kompatibel und bei VC mit großer Sensorvielfalt erhältlich: MIPI Kameramodule sorgen für die Bilderfassung in zahlreichen Embedded Vision Anwendungen.

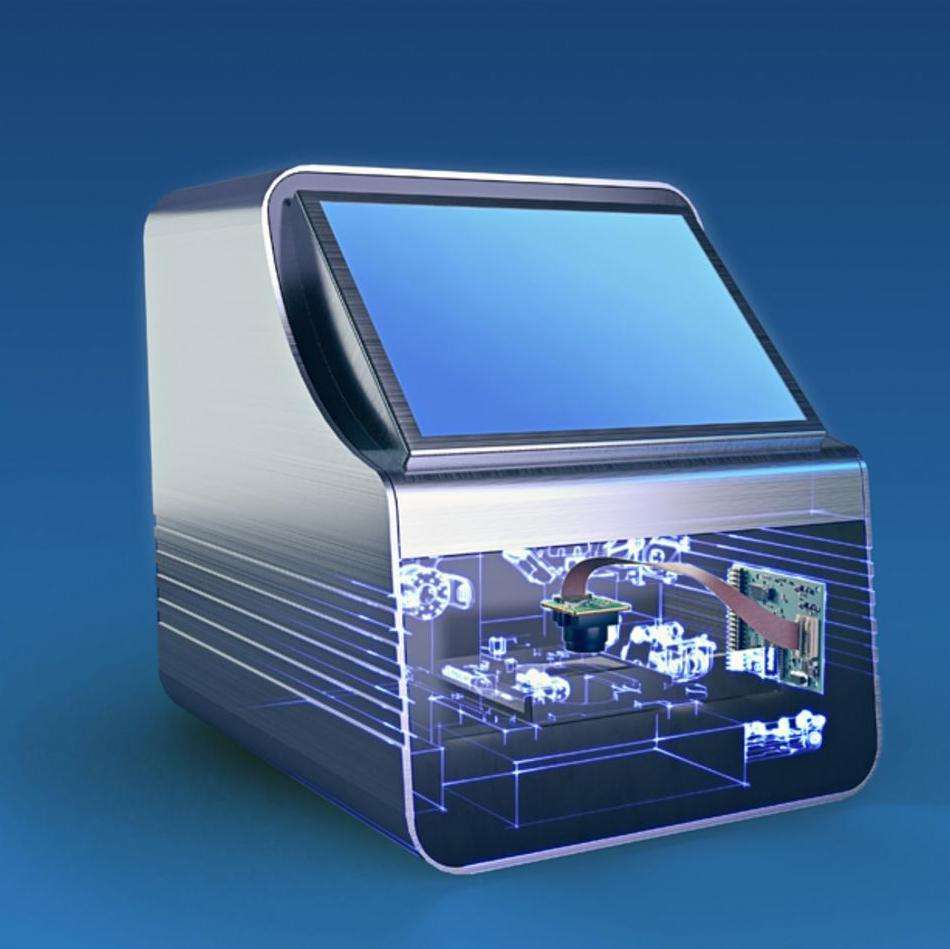

Kameramodule und CPUs in einer Einheit

Diese intelligenten Platinenkameras verbinden Bilderfassung und Bildverarbeitung – entweder komplett auf einer ultrakompakten Platine oder mit ein- oder mehreren abgesetzten Sensorköpfen für die flexible Integration in Geräte und Maschinen.

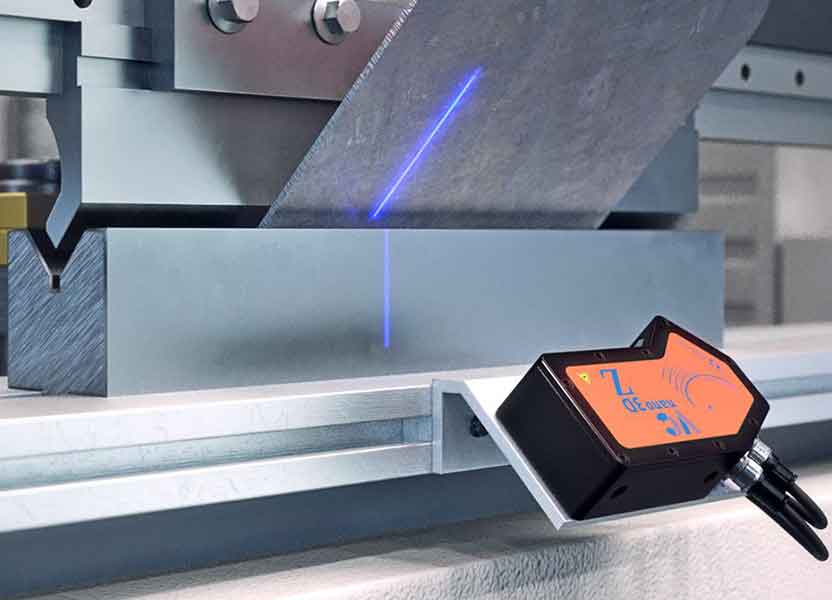

Ready-to-use Sensoren auf Basis von Embedded Vision

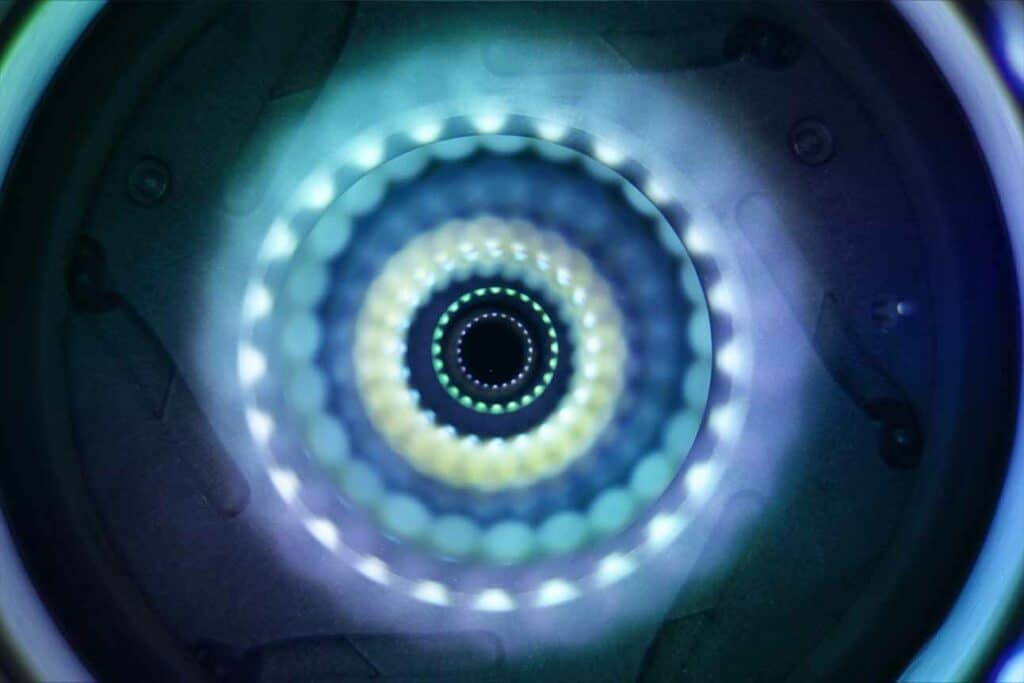

Embedded Vision Systeme von VC gibt es auch in robusten Schutzgehäusen und je nach Variante mit Beleuchtung oder Linienlasermodulen für 3D-Triangulationsanwendungen. Damit sind sie direkt einsatzbereit oder die ideale Basis für individuelle OEM-Sensoren.

Applikationen und Aufgaben für Embedded Vision:

- 2D und 3D-Messtechnik

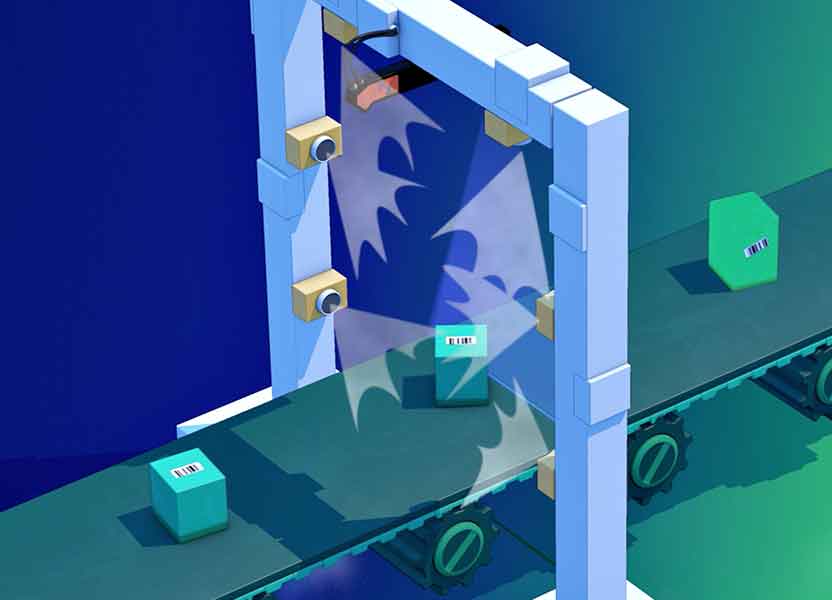

- Code lesen: 1D(Barcode) + 2D (Data Matrix)

- Konturerkennung: unabhängig von Drehlage und verdeckten Objekten

- Vollständigkeitskontrolle

- Positionierung und Alignment

- Produktinspektion

- Nummernschilderkennung

- Parkmanagement

- Zugangskontrolle

- Identifikation von Werkzeugen

- Multi-Kamera-Applikationen

- Autonomes Fahren & ITS

- Drohnen

- Smart-City/Smart-Traffic

- Robotik

- Laborautomation

Embedded Vision in der Praxis: So profitieren Anwendungen von der intelligenten Bildverarbeitung

Hohe Rechenleistung moderner Embedded Prozessoren, die effiziente Nutzung von ARM-Cores, FPGAs und speziellen Prozessoreinheiten wie GPUs, IPSs, NPUs etc. und all das in Verbindung mit niedriger Stromaufnahme und kompaktem Design: Die Anwendungsmöglichkeiten für Embedded Vision Systeme sind unbegrenzt und schon heute kommen sie in allen Branchen und Industrien zum Einsatz – auch in Anwendungen, die in der Vergangenheit mit Systemen auf Basis von PCs ausgestattet waren. Sie sind autark, verzichten auf alle nicht benötigten Komponenten und können dank der geringen Größe nahezu überall integriert werden. Damit bieten sie entscheidende technische Vorteile und sind ideal für den Einsatz in Edge Devices, Handhelds und mobilen Geräten. In Verbindung mit Künstlicher Intelligenz sind Embedded Vision Systeme die Basis für zahlreiche innovative und smarte Applikationen, die derzeit in Bereichen wie Smart Farming & Agriculture, Intelligent Traffic, Smart Appliances, Smart Factory & Logistics sowie in Health, Medical & Life Sciences entstehen.

Seit über 25 Jahren weltweit bewährt

Kameramodule und Vision-Systeme von VC werden erfolgreich in zahlreichen Industrien und Anwendungen eingesetzt – in der Messtechnik, Automatisierung und Qualitätssicherung ebenso wie in Robotern, intelligenten Haushaltsgeräten und Lösungen für Smart Cities, in Drohnen und Sonderfahrzeugen, in der Medizintechnik und Laborgeräten. Einige Projekte und Unternehmen, die auf unsere OEM-Komponenten für Embedded Vision setzen, stellen wir hier vor.

Sie wollen ebenfalls von Embedded Vision profitieren?

Dann lesen Sie weiter, wie Sie Kameras und Bildverarbeitung am besten in Ihr Projekt integrieren können. Und schreiben Sie uns Ihre Fragen!

Wir haben die drei effizientesten Wege zur Integration von Embedded Vision in diesem weiterführenden Blogbeitrag zusammengestellt. Und freuen uns, Sie bei Ihren individuellen Projekten und Herausforderungen zu unterstützen.