Technologische Entwicklungen und Fortschritte

Smartphones, Rückfahrkameras und Pfandautomaten, Inspektionssysteme in Produktionsanlagen und autonome mobile Roboter: Kameras sind nicht mehr aus unserem Alltag wegzudenken. Dabei sind die Sensoren ganz natürlich und perfekt in ihre Anwendungen integriert – entsprechend der Definition von Embedded Vision. Consumer-Elektronik und Automobilindustrie sind wichtige Treiber für diese Entwicklung hin zu miniaturisierten Kameras und immer leistungsstärkeren Embedded Prozessorboards. In diesem Blogbeitrag wollen wir einen Blick werfen auf die Anfänge von Embedded Vision und die technische Entwicklung der vergangenen 30 Jahre.

Von den ersten Embedded Systemen bis zur Erfindung der intelligenten Kamera

Der Apollo Guidance Computer mit einem Arbeitsspeicher von 2 KBytes und einer Taktrate von 100 Kilohertz kann als Vorläufer der heutigen Embedded Systeme angesehen werden. Er war der erste Computer, der auf integrierten Siliziumschaltungen basierte und wurde für das Apollo-Programm zu Beginn der bemannten Raumfahrt entwickelt. 1966 erstmals eingeführt, lieferte der Computer Berechnungen und Schnittstellen für die Steuerung, Navigation und Kontrolle des Raumfahrzeugs.

Es dauerte danach weitere 30 Jahre, bis die ersten Embedded Systeme für Bildverarbeitungsanwendungen entwickelt wurden. Bis zu diesem Zeitpunkt wurden Kameras eingesetzt, die an externe Verarbeitungseinheiten angeschlossen waren. Diese lieferten die nötige Rechenleistung für die Verarbeitung der Bilddaten – mit der Größe eines Tower-PCs waren sie allerdings weit davon entfernt, „eingebettet“ zu sein.

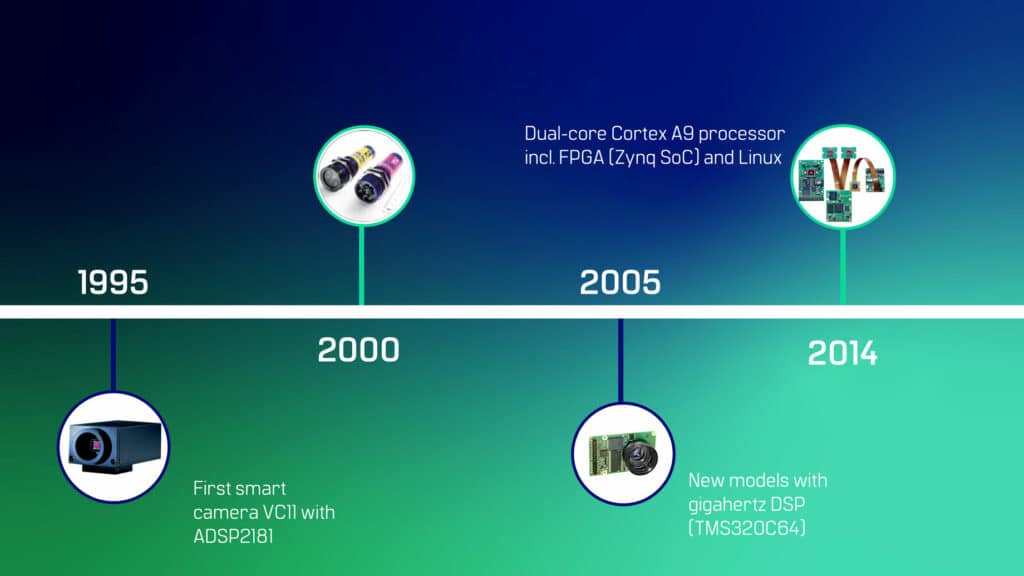

1995 stellte Michael Engel die VC11 vor, die erste industrielle Smart-Kamera der Welt, die auf einem digitalen Signalprozessor (DSP) basiert. Sein Ziel war es, ein kompaktes System zu schaffen, das Bilderfassung und -verarbeitung im selben Gerät ermöglicht. Die Kamera wurde im Vergleich zu PC-basierten Systemen zu deutlich geringeren Kosten angeboten und war wegweisend für die heutigen Smart-Kameras und Embedded Vision Systeme. Diese Erfindung markierte auch die Gründung von Vision Components durch Michael Engel.

Die 1990er Jahre: Homogene Embedded Vision Systeme

In den folgenden Jahren wurden DSPs zum Standard für die Bildverarbeitung mit intelligenten Kameras. Die Technologie entwickelte sich von den ersten Chips von Unternehmen wie Analog Devices zu hochentwickelten Modellen mit Gigahertz-Rechenleistung von Texas Instruments in den ersten Jahren des 21. Jahrhunderts, aber das Grundprinzip blieb gleich: Die Bilddaten wurden von einem Bildsensor erfasst, der von einem DSP gesteuert wurde. Anschließend wurden die Daten über einen Bus-Controller in den internen Speicher übertragen. Die gesamte Verarbeitung fand in einer einzigen Verarbeitungseinheit statt. Mit der schnell fortschreitenden Entwicklung leistungsfähiger DSPs wurden damit sogar Anwendungen wie 3D-Profilsensoren mit Onboard-Datenverarbeitung möglich.

Dual-Core ARM Prozessoren mit FPGA:

Meilenstein für die Entwicklung von Embedded Vision

Ein Meilenstein für die Entwicklung von Embedded-Vision-Systemen war die Einführung von Dual-Core-ARM-Prozessoren mit FPGA von Xilinx. Vision Components entwickelte 2014 seine ersten Embedded Vision Systeme auf Basis dieser heterogenen Architektur. Sie kombinierten die Vorteile der parallelen Echtzeitverarbeitung des FPGAs mit einem frei programmierbaren Linux-Betriebssystem auf den ARM-Cores. Dieser Aufbau machte das Design von Embedded Vision Systemen vielseitiger und flexibler und eröffnete den Entwicklern ganz neue Möglichkeiten, Software für ihre spezifischen Anwendungen zu programmieren und zu implementieren.

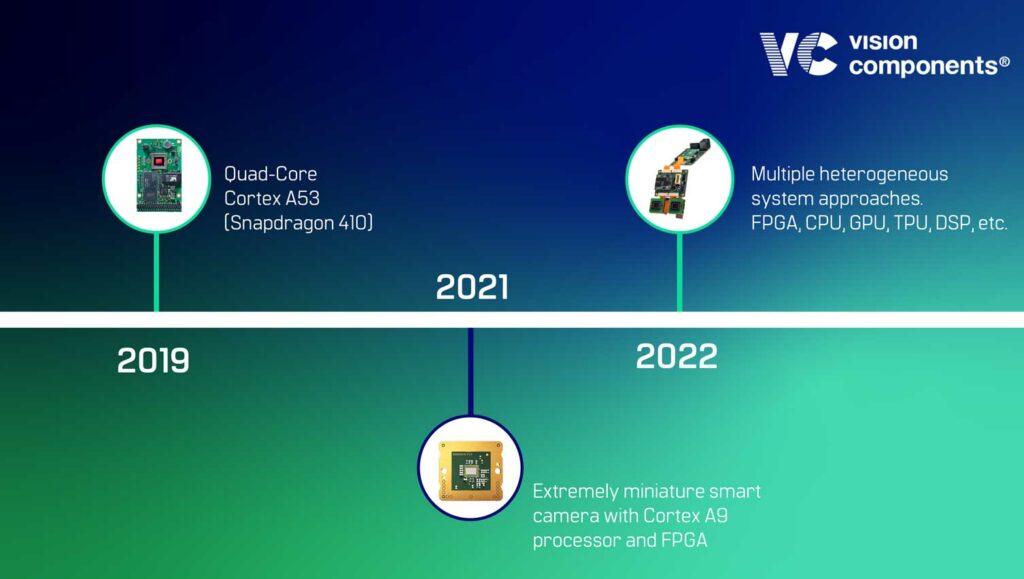

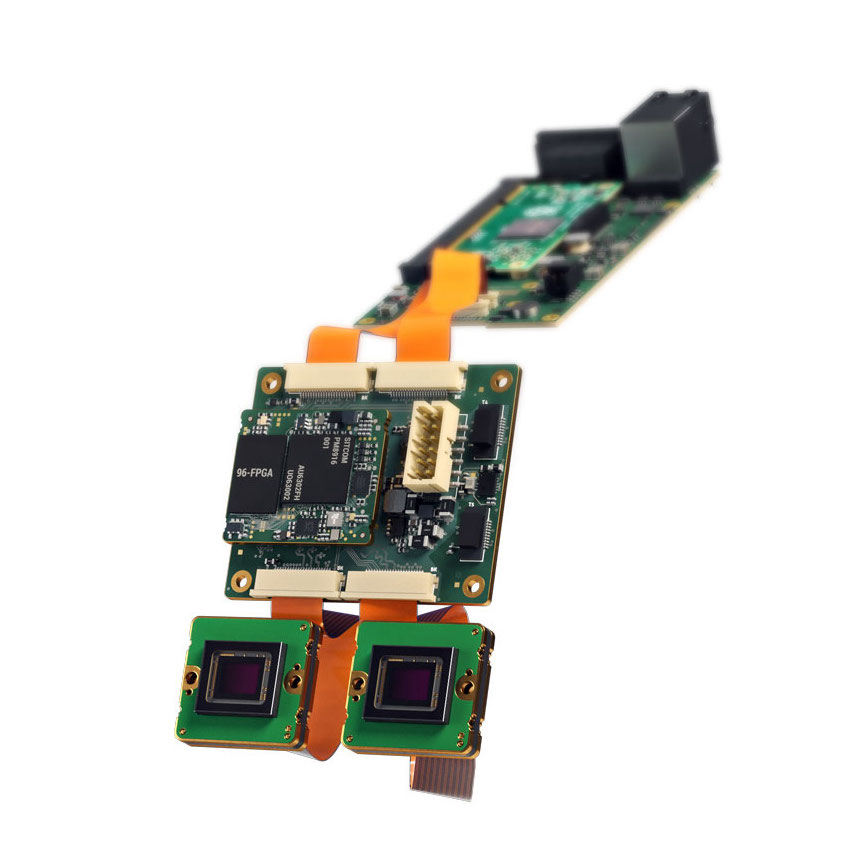

Die Rechenleistung stieg mit der Einführung neuer Prozessoren, getrieben durch die hohe Nachfrage nach kleiner und leistungsfähiger Elektronik für Anwendungen in der Automobilindustrie, in Automatisierung und Smart Home. Infolgedessen wurden Embedded Bildverarbeitungssysteme für zahlreiche und ganz unterschiedliche Einsatzbereiche entwickelt, von Board-Level-Kameras mit mehreren Prozessorkernen bis hin zu extrem kleinen Embedded Vision Systemen, die Bilderfassung und -verarbeitung mit ARM-Prozessoren und FPGAs auf einem einzigen Board von der Größe einer Briefmarke kombinieren.

1996 bis heute: Vision Components Meilensteine in der Entwicklung von Embedded Vision

Von der weltweit ersten intelligenten Kamera für die Industrie über die Entwicklung und Fertigung von Platinen- und Gehäusekameras bis hin zum innovativen FPGA-Booster VC PowerSoM – Vision Components hat mit seinen Meilensteinen die Weiterentwicklung innovativer Embedded Vision Produkte maßgeblich geprägt und vorangetrieben.

State of the Art Embedded Vision Technologien: Smart, flexibel und ultrakompakt

Stand der Technik sind heute heterogene Systemansätze mit mehreren Prozessoreinheiten, die sowohl ARM-CPUs und High-End-FPGAs als auch spezialisierte Verarbeitungseinheiten wie DSPs, Graphics Processing Units (GPUs), speziell für das maschinelle Lernen entwickelte Tensor Processing Units (TPUs) und KI-optimierte Neuronal Processing Units (NPUs) nutzen. Für Design und Entwicklung solcher Systeme stehen zahlreiche Prozessorboards und System on Modules zur Auswahl, auf denen die entsprechenden Prozessoreinheiten bereits integriert sind. Für noch mehr Flexibilität können verschiedene Module kombiniert werden. Im Ergebnis profitieren Entwickler so von einer größtmöglichen Freiheit bei der Auswahl des Prozessors für die Hauptanwendung, von einer schnellen, kostengünstigen Entwicklung und damit einer kürzeren Zeit bis zur Serienreife.

Sie wollen Teil der Embedded Vision Erfolgsgeschichte sein?

Dann lesen Sie weiter, wie Sie Embedded Vision am besten in Ihr Projekt integrieren können. Und schreiben Sie uns Ihre Fragen!

Wir haben die drei effizientesten Wege zur Integration von Embedded Vision in diesem weiterführenden Blogbeitrag zusammengestellt. Und freuen uns, Sie bei Ihren individuellen Projekten und Herausforderungen zu unterstützen.